一探究竟:10个独领风骚的Python自动化实战剧本,解锁生产力的智慧之匙

1、日志洞悉乾坤:透过Python的慧眼,深度揭秘日志文件中的奥秘——自动化解析与关键信息提炼的艺术

def delve_into_log(log_path: str) -> None:

"""

深度解读日志迷宫,揭示其中的错误轨迹。

参数:

log_path (str): 待分析的日志文件路径

返回:

无,但在终端输出日志文件中错误记录的数量

"""

with open(log_path, 'r', encoding='utf-8') as mystic_scroll:

log_entries = mystic_scroll.readlines()

errata_counter = 0

for enigmatic_line in log_entries:

if "ERROR" in enigmatic_line:

errata_counter += 1

print(f"在这卷《日志万象》中,共记载了 {errata_counter} 段错误篇章。")

# 使用示例:

delve_into_log('application.log')2、自动化测试:驾驭Python locust库,挥舞性能测试的利剑,探秘API接口承压极限的壮阔画卷

在编程艺术的殿堂里,我们借助Python之翼——Locust,编织了一场宏大的API压力测试交响乐。请欣赏如下乐章:

```python

# 导入英勇的HttpUser与关键的任务指挥家

from locust import HttpUser as Warrior, task, between

# 创建名为WebsiteAuditor的勇士角色,其行动间歇如诗般流淌

class WebsiteAuditor(Warrior):

# 设定勇士思索与行动的间隔,如同舞者在舞台上的华丽转身,介于5至15秒之间

wait_time = between(5, 15)

# **探索之旅:负载检验API**

@task

def embark_on_load_quest(self):

# 向'/api/data'发起无畏的求索

the_response = self.scout.dispatch_get("/api/data")

# 确保探险归来航标——HTTP状态码,揭示成功的200信号

assert the_response.status_code == 200

# **力量试炼:高频模拟数据投递**

@task(weight=3) # 此重任承载三倍勇气,比其他挑战更为频繁地展现

def deliver_data_to_the_gate(self):

# 准备珍贵的数据贡品

offering = {"key": "value"}

# 向'/api/submit'勇猛进击,呈上数据宝典

transmission_result = self.scout.post("/api/submit", json=offering)

# 确认传送门已稳稳开启,以HTTP状态码201作为创世成功的印记

assert transmission_result.status_code == 201

# 现在,唤起Locust大军,奏响这场壮丽的性能战役序曲:

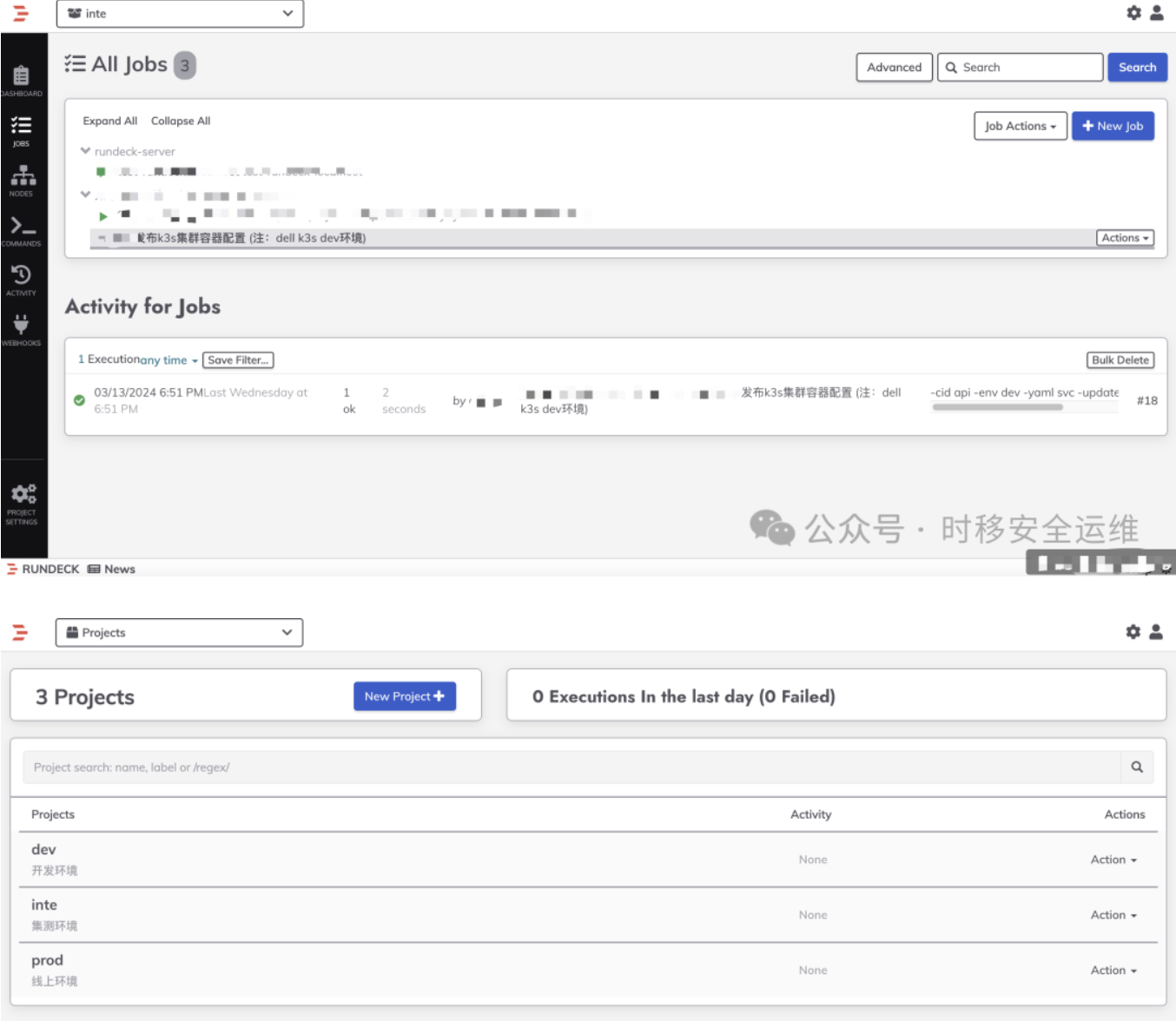

# locust -f 你的编撰手稿.py --host=http://你的-API-入口.com3、自动化部署&回滚:在编程世界的智慧星河中,让我们借由Python中的神秘织锦——Fabric库,挥舞数字化的经纬,编制一幅SSH远程部署的壮丽画卷。此刻,就让我们以神圣的Django项目作为我们的领航星辰,演绎一场自动化部署与回滚的时空传奇:

# 寻梦织云,载物飞翔:通过Fabric来施展SSH远程部署的魔力

from fabric import Connection

# 定义星际驿站:目标服务器的身份坐标

env.hosts = ['your_server_ip']

# 编纂部署圣典:执行在远端服务器上的部署仪式

def deploy_django_constellation():

# 连接至遥远的天际,建立跨越空间的桥梁

cosmic_gateway = Connection(env.hosts[0])

# 进入承载Django宇宙的孵化室(项目目录)

with cosmic_gateway.cd('/path/to/django/project'):

# 获取最新的星辰轨迹(拉取代码更新)

cosmic_gateway.run('git pull origin master')

# 唤醒沉睡的宇宙之力(安装依赖)

cosmic_gateway.run('pip install -r requirements.txt')

# 炼化星辰之力,构建宇宙秩序(收集静态文件)

cosmic_gateway.run('python manage.py collectstatic --noinput')

# 推动时空轮转,重启星辰引擎(重启服务)

cosmic_gateway.run('systemctl restart django_service')

# 留下诗意的回声,宣告部署的凯歌

print("星辰大海,新版本已在苍穹之上点亮!")

# 编写逆转乾坤,一键回滚的法术

def rollback_to_previous_starburst():

# 与前述相似,首先连接至远端服务器

celestial_portal = Connection(env.hosts[0])

# 进入特定的时间裂隙(回滚到上一个Git标签)

with celestial_portal.cd('/path/to/django/project'):

celestial_portal.run('git checkout <previous_tag>')

# 再次唤醒宇宙之力,确保环境同步

celestial_portal.run('pip install -r requirements.txt')

# 回收重构的星辰碎片(重新收集静态文件)

celestial_portal.run('python manage.py collectstatic --noinput')

# 重启星辰引擎,恢复旧日宇宙秩序

celestial_portal.run('systemctl restart django_service')

# 法术完成,历史的星尘重归原位

print("时光逆流,星辰回溯,前一版宇宙秩序已复原。")

# 如同驾驭星辰之舟,只需轻轻一击,即可启程

# fab deploy_django_constellation 或 fab rollback_to_previous_starburst

4、智慧报告系统:自动采集数据,定时生成并并按期递送的「朝暮日报」与「时空周志」,让您洞悉业务动态,决胜千里之外。

# 引入所需库

import pandas as pd

from email.mime.text import MIMEText

from email.mime.multipart import MIMEMultipart

import smtplib

from apscheduler.schedulers.blocking import BlockingScheduler

def generate_and_send_report(source, to_address, subject, smtp_server, port, login_email, login_password):

# 根据源(数据库或文件)生成报告内容

if isinstance(source, str): # 假设source是文件名

df = pd.read_csv(source)

report_content = df.to_html() # 将DataFrame转换为HTML格式

else: # 假设source是从数据库获取的数据

# 这里仅作为示例,实际应用中需要写查询数据库的代码

df = pd.DataFrame({"Data": [1, 2, 3], "Info": ["A", "B", "C"]})

report_content = df.to_html()

# 创建邮件消息对象

msg = MIMEMultipart()

msg['From'] = login_email

msg['To'] = to_address

msg['Subject'] = subject

# 添加HTML格式的报告内容到邮件附件

msg.attach(MIMEText(report_content, 'html'))

# 连接SMTP服务器并发送邮件

with smtplib.SMTP(smtp_server, port) as server:

server.starttls()

server.login(login_email, login_password)

text = msg.as_string()

server.sendmail(login_email, to_address, text)

# 定时任务配置及执行

def schedule_report_generation():

scheduler = BlockingScheduler()

# 示例:每天固定时间发送日报

def daily_report_job():

generate_and_send_report(

'data.csv',

'receiver@example.com',

'每日数据洞察报告',

'smtp.example.com',

587,

'your-email@example.com',

'your-password'

)

# 每天上午9点运行日报生成任务

scheduler.add_job(daily_report_job, 'cron', hour=9)

# 启动调度器

scheduler.start()

# 若要启动定时发送功能,请调用schedule_report_generation函数

schedule_report_generation()

5、Python邮件附件智取术:一键解析,轻松下载海量邮件附件,让您的工作效率飞跃提升!

import imaplib

import email

from email.header import decode_header

import os

def harvest_attachments(email_identity, email_credential, imap_gateway, mailbox='INBOX'):

"""

连接到指定的IMAP服务器,检索指定邮箱下的所有邮件,并智能地提取并保存其附件。

参数:

email_identity (str): 邮箱账号

email_credential (str): 邮箱密码

imap_gateway (str): IMAP服务器地址

mailbox (str): 默认为'INBOX',即检查的邮箱文件夹

返回:

无;直接在指定路径下保存邮件附件

"""

digital_postman = imaplib.IMAP4_SSL(imap_gateway)

digital_postman.login(email_identity, email_credential)

digital_postman.select(mailbox)

_, message_uids = digital_postman.uid('search', None, "ALL")

for unique_envelope_id in message_uids[0].split():

_, full_message_bytes = digital_postman.uid('fetch', unique_envelope_id, '(RFC822)')

encoded_email_text = full_message_bytes[0][1]

decoded_email = encoded_email_text.decode("utf-8")

parsed_letter = email.message_from_string(decoded_email)

for parcel in parsed_letter.walk():

if parcel.get_content_maintype() == 'multipart':

continue # 跳过分割的邮件部分

attachment_declaration = parcel.get('Content-Disposition')

if attachment_declaration is None:

continue # 跳过没有声明为附件的部分

attached_file_name = decode_header(parcel.get_filename())[0][0]

if attached_file_name: # 确保文件名存在且非空

encapsulated_document = parcel.get_payload(decode=True)

save_path = os.path.join('/path/to/your/library', attached_file_name)

with open(save_path, 'wb') as archival_chamber:

archival_chamber.write(encapsulated_document)

digital_postman.close()

digital_postman.logout()

# 使用示例:

harvest_attachments('your-email@example.com', 'your-password', 'imap.example.com')

6、智慧绘图助手:Matplotlib自动化数据可视化,一图胜千言,让数据之美跃然屏上!

import matplotlib.pyplot as plt

import pandas as pd

def illustrate_data_epiphany(data_manifesto):

"""

通过神秘的CSV宇宙汲取数据之泉,挥洒艺术之笔,描绘出深邃而直观的统计画卷。

参数:

data_manifesto (str): 数据源泉的坐标指向——CSV文件名

描述:

此函数犹如一座桥梁,联结了冰冷的数据与鲜活的视觉表达,借助pandas的力量破译数据矩阵,

并采用matplotlib的丹青技法,以其‘柱状图’形式展现数据在不同类别间的分布态势。

使用时,宛如点亮一盏明灯,照亮数据暗夜:

"""

dataframe_cosmos = pd.read_csv(data_manifesto)

# 前方高能:以类别为经,数值为纬,构筑一幅数据分布的立体景观

dataframe_cosmos.plot(kind='bar', x='category', y='value')

# 绘卷标题,点睛之作

plt.title('数据的韵律与分布:一场无声的交响乐')

plt.xlabel('五彩斑斓的类别世界')

plt.ylabel('起伏跌宕的价值轨迹')

# 映入眼帘,豁然开朗

plt.show()

# 使用示例,邀请您共赏《数据星辰》:

illustrate_data_epiphany('data.csv')

7、查找与替换: Python一键遍历文件,智能搜寻与替换文案法术,文件内容尽在掌控,让你的文本编辑更高效

# 题目:游弋字宙·批量文件内容的智慧探寻与重塑之旅

import fileinput

def voyage_through_textual_universe(dir_path, sought_treasure, replacement_gem):

"""

探索指定目录下的每一个文本领域,犹如摆渡人在字宙中穿行,寻找遗落的旧词珍宝,

并以新词明珠替换,以此焕发文采斐然的新篇章。

参数:

dir_path (str): 欲航行探索的文本宇宙根目录

sought_treasure (str): 需要在字宙中搜寻的旧词瑰宝

replacement_gem (str): 替代旧词的崭新概念宝石

描述:

此函数引领使用者踏上一场穿越无数文本篇章的旅程,凭借强大的搜索与替换能力,

于字里行间发掘价值,将陈旧之意转化为新颖理念,成就一场文本的重生蜕变。

"""

for lyrical_thread in fileinput.input([f"{dir_path}/*"], inplace=True):

print(lyrical_thread.replace(sought_treasure, replacement_gem), end='')

# 使用示例,启动这场文本涅槃之旅:

voyage_through_textual_universe('/path/to/your/textual/universe', '昔日篇章', '今朝辞藻')

8、Pandas数据净化师:自动化处理清洗,让数据焕然一新,揭示隐藏在其中的智慧宝藏!一键处理复杂数据,让你的数据焕发新生,精准洞察业务本质!

# 题目:涤净凡尘·以Python pandas修炼数据清泉之道

导入pandas这一数据分析利器,我们编撰了一则数据洗涤与转化的修行法门,旨在还原数据最纯粹的本质。

```python

import pandas as pd

def purify_data_lake(file_stream):

"""

以Pandas为舟,泛游于数据湖泊之中,展开一场荡涤杂质、重塑秩序的净化之旅。

参数:

file_stream (str): 指引通向原始数据湖的径道(即文件路径)

描述:

此函数仿佛是一位经验丰富的数据工匠,针对输入的CSV文件进行深度梳理与重塑。

实践环节:

- 以'N/A'填补湖泊中散落的空白之处,赋予其清晰标识;

- 撇去波光下的冗余倒影,裁剪掉重复的数据行,留存唯一真实的映像;

- 对于时间的涟漪,甄别并转换其本质形态,使其化身为严谨有序的日期列。

返回:

一池澄清透明、焕发新生的数据清泉(即清理后得到的数据帧)。

"""

# 诵读湖面之上的CSV梵文,摄取其中蕴含的数据气息

pure_spring = pd.read_csv(file_stream)

# 以'N/A'填充湖底遗留的砂砾空隙,使之完整如镜

pure_spring.fillna('N/A', inplace=True)

# 挥舞剔除重复幻影的拂尘,还原本真澄澈之态

pure_spring.drop_duplicates(inplace=True)

# 对于湖面上流转的时间涟漪,施以时序变换之法,凝练为统一格式的日期珍珠

pure_spring['date_column'] = pd.to_datetime(pure_spring['date_column'])

# 归还洗净铅华、整理有序的数据清泉予世间

return pure_spring

# 使用示例,舀取一瓢洁净数据之泉:

cleansed_data_fountain = purify_data_lake('data.csv')

print("数据洗礼完毕,已然纯净如泉,静候剖析与解读!")9、Python智能调度师:在时间的长河中嵌入一段Python编写的梦幻篇章,我们运用schedule库的力量,构筑了一座跨越昼夜的自动化时钟塔楼。这座塔楼于每日旭日初升之刻(上午9时),悄然敲响思维的钟声,低吟浅唱出当日的时光寄语。

# 题目:流年咏叹·Python时钟诗篇每日九时的自动化唤醒颂歌

import schedule # 导入时间编织者的秘密法则

import time # 拥抱岁月流转的实时见证者

def sonnet_of_the_hour():

"""

日常冥思的诗歌片段,于每日特定时辰绽放智慧的花朵。

描述:

此函数象征着每日例行的心灵洗礼,于每日清晨9时整,

它将会吟唱出当下的时光印记,唤醒沉睡的思想火花。

执行动作:

输出当前的宇宙瞬息(时间戳)以及一句诗意的召示。

"""

print(f"此刻光阴:{time.ctime()},思考的翅膀正翩翩起舞...")

# 为这颗时间种子播种规律,每日破晓时分(9:00)绽放思绪的花蕾

schedule.every().day.at("09:00").do(sonnet_of_the_hour)

# 让时间编织者在永恒的循环中持续守望,适时唤醒心中的诗篇

while True:

schedule.run_pending() # 守护时间法则,等待唤醒时刻的到来

time.sleep(1) # 温柔地驻足片刻,感受时光荏苒的微妙流动

# 使用示例:

# 当你启动这段Python魔法,每日上午9时,都会有一位隐形的诗人

# 在你耳边低语,告诉你此刻宇宙的呼吸,引导你进入新的一天的哲思之旅。

10、Python爬虫大师:BeautifulSoup与requests联袂,自动化抓取网页内容,信息尽在指尖!

# 题目:穿云逐浪·Python编织Web探索之舟,萃取网页深处的醒目标题

import requests # 引导我们穿越网络瀚海的航船

from bs4 import BeautifulSoup # 解析沿途风景的智慧之匙

def navigate_web_ocean(target_url):

"""

驾驭Requests之舟,探访指定URL的浩渺网络空间,挖掘其中的醒目标题。

参数:

target_url (str): 触发此次探索之旅的目的地坐标

返回:

若抵达彼岸成功,将以文本形式携带那片网络海域的显赫标题;

若遭遇风浪,将携带着“无法获取网页内容”的航海日记归来。

"""

response_journey = requests.get(target_url) # 发起对未知领域的探索

if response_journey.status_code == 200: # 若成功登陆彼岸

html_map = BeautifulSoup(response_journey.text, 'html.parser') # 绘制出网页的地图

# 在地图中探寻并发现那枚承载着网页灵魂的徽章——标题

significant_emblem = html_map.find('title').text

return significant_emblem

else:

return "无法获取网页内容" # 若未能抵达,唯有寄语遗憾

# 使用示例:

treasure_map = 'https://example.com' # 揭示一张指引探索的目标地图

significant_emblem_discovered = navigate_web_ocean(treasure_map)

print("揭示之旅成果:网页的灵魂印记——", significant_emblem_discovered)